Энтропия источника независимых сообщений. До сих пор определялось количество информации, содержащееся в отдельных сообщениях. Вместе с тем во многих случаях, когда требуется согласовать канал с источником сообщений, таких сведений оказывается недостаточно. Возникает потребность. в характеристиках, которые, бы позволяли оценивать информационные свойства источника сообщений в целом. Одной из важных характеристик такого рода является среднее количество информации, приходящееся на одно сообщение.

В простейшем случае, когда все сообщения равновероятны, количество информации в каждом из них одинаково и, как было показано выше, определяется выражением (6.3). При этом среднее количество информации равно log т. Следовательно, при равновероятных независимых сообщениях информационные свойства источника зависят только от числа сообщений в ансамбле т.

Однако в реальных условиях сообщения, как правило, имеют разную вероятность. Так, буквы алфавита О, Е, А встречаются в тексте сравнительно часто, а буквы Щ, Ы, Ъ — редко. Поэтому знание числа сообщений т в ансамбле является недостаточным, необходимо иметь сведения о вероятностях каждого сообщения: ![]() .

.

Так как вероятности сообщений неодинаковы, то они несут различное количество информации J(a![]() )=-logP(a

)=-logP(a![]() ). Менее вероятные сообщения несут большее количество информации и наоборот. Среднее количество информации, приходящееся на одно сообщение источника, определяется как математическое ожидание J(a

). Менее вероятные сообщения несут большее количество информации и наоборот. Среднее количество информации, приходящееся на одно сообщение источника, определяется как математическое ожидание J(a![]() ):

):

![]() (6.6)

(6.6)

Величину Н(а) называется энтропией. Этот термин заимствован из термодинамики, где имеется аналогичное по своей форме выражение, характеризующее неопределенность состояния физической системы. В теории информации энтропия Н(а) также характеризует неопределенность ситуации до передачи сообщения, поскольку заранее неизвестно, какое из сообщений ансамбля источника будет передано. Чем больше энтропия, тем сильнее неопределенность и тем большую информацию в среднем несет одно сообщение источника.

В качестве примера вычислим энтропию источника сообщений, который характеризуется ансамблем, состоящим из двух сообщений ![]() и

и ![]() с вероятностями

с вероятностями ![]() и

и ![]() . На основании (6.6) энтропия такого источника будет равна:

. На основании (6.6) энтропия такого источника будет равна:

![]()

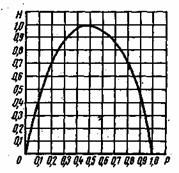

Рис. 6.1. Зависимость энтропии от вероятности р

Зависимость Н(а) от р показана на рис. 6.1. Максимум имеет место при р=1/2, т. е. когда ситуация является наиболее неопределенной. При р=1 или р=0, что соответствует передаче одного из сообщений ![]() или

или ![]() , неопределенность отсутствует. В этих случаях энтропия Н(а) равна нулю.

, неопределенность отсутствует. В этих случаях энтропия Н(а) равна нулю.

Среднее количество информации, содержащееся в последовательности из п сообщений, равно:

![]()

Отсюда следует, что количество передаваемой информации можно увеличить не только за счет увеличения числа сообщений, но и путем повышения энтропии источника, т. е. информационной емкости его сообщений.

Обобщая полученные выше результаты, сформулируем следующие основные свойства энтропии источника независимых сообщений (6.6):

— энтропия— величина всегда положительная, так как ![]()

— при равновероятных сообщениях, когда ![]() , энтропия максимальна и равна:

, энтропия максимальна и равна:

![]() (6.7)

(6.7)

— энтропия равняется нулю лишь в том случае, когда все вероятности Р(a![]() ) равны нулю, за исключением одной, величина которой ,равна единице;

) равны нулю, за исключением одной, величина которой ,равна единице;

— энтропия нескольких независимых источников равна сумме энтропии этих источников ![]() .

.

Энтропия источника зависимых сообщений. Рассмотренные выше источники независимых дискретных сообщений являются простейшим типом источников. В реальных условиях картина значительно усложняется из-за наличия статистических связей между сообщениями. Примерам может быть обычный текст, где появление той или иной буквы зависит от предыдущих буквенных сочетаний. Так, например, после сочетания ЧТ вероятность следования гласных букв О, Е, И больше, чем согласных.

Статистическая связь ожидаемого сообщения с предыдущим сообщением количественно оценивается совместной вероятностью ![]() или условной вероятностью

или условной вероятностью ![]() , которая выражает вероятность появления сообщения

, которая выражает вероятность появления сообщения ![]() при условии, что до этого было передано сообщение а

при условии, что до этого было передано сообщение а![]() Количество информации, содержащееся в сообщении

Количество информации, содержащееся в сообщении ![]() , при условии, что известно предыдущее сообщение а

, при условии, что известно предыдущее сообщение а![]() согласно (6.1) будет равно:

согласно (6.1) будет равно:![]() . Среднее количество информации при этом определяется условной энтропией

. Среднее количество информации при этом определяется условной энтропией ![]() , которая вычисляется как математическое ожидание информации

, которая вычисляется как математическое ожидание информации ![]() по всем возможным сообщениям а

по всем возможным сообщениям а![]() и

и ![]() . Учитывая соотношение (2.25), .получаем

. Учитывая соотношение (2.25), .получаем

![]() (6.8)

(6.8)

В тех случаях, когда связь распространяется на три сообщения ![]() , условная энтропия источника определяется аналогичным соотношением

, условная энтропия источника определяется аналогичным соотношением

![]() (6.9)

(6.9)

В общем случае n зависимых сообщений

![]() (6.10)

(6.10)

Важным свойством условной энтропии источника зависимых сообщений является то, что при неизменном количестве сообщений в ансамбле источника его энтропия уменьшается с увеличением числа сообщений, между которыми существует статистическая взаимосвязь. В соответствии с этим свойством, а также свойством энтропии источника независимых сообщений можно записать неравенства

![]() (6.11)

(6.11)

Таким образом, наличие статистических связей между сообщениями всегда приводит к уменьшению количества информации, приходящегося в среднем на одно сообщение.

Избыточность источника сообщений. Уменьшение энтропии источника с увеличением статистической взаимосвязи (6.11) можно рассматривать как снижение информационной емкости сообщений. Одно и то же сообщение при наличия взаимосвязи содержит в среднем меньше информации, чем при ее отсутствии. Иначе говоря, если источник создает последовательность сообщений, обладающих статистической связью, и характер этой связи известен, то часть сообщений, выдаваемая источником, является избыточной, так как она может быть восстановлена по известным статистическим связям. Появляется возможность передавать сообщения в сокращенном виде без потери информации, содержащейся в них. Например, при передаче телеграммы мы исключаем из текста союзы, предлоги, знаки препинания, так как они легко восстанавливаются, при чтении телеграммы на основании известных правил построения фраз и слов.

Таким образом, любой источник зависимых сообщений, как принято говорить, обладает избыточностью. Количественное определение избыточности может быть получено из следующих соображений. Для того чтобы передать количество информации, источник без избыточности должен выдать в среднем ![]() сообщений, а источник с избыточностью

сообщений, а источник с избыточностью ![]() сообщений.

сообщений.

Поскольку ![]() и

и ![]() , то для передачи одного и того же количества информации источник с избыточностью должен использовать большее количество сообщений. Избыточнее количество сообщений равно kn-k0, а избыточность определяется как отношение

, то для передачи одного и того же количества информации источник с избыточностью должен использовать большее количество сообщений. Избыточнее количество сообщений равно kn-k0, а избыточность определяется как отношение

![]() (6.12)

(6.12)

Величина избыточности лежит в пределах ![]() и согласно (6.11) является неубывающей функцией п. Для русского языка, например,

и согласно (6.11) является неубывающей функцией п. Для русского языка, например, ![]() дв. ед.,

дв. ед., ![]() ,

, ![]() ,

, ![]() дв. ед. Отсюда на основании (6.12) для русского языка получаем избыточность порядка 50%.

дв. ед. Отсюда на основании (6.12) для русского языка получаем избыточность порядка 50%.

Коэффициент

![]() (6.13)

(6.13)

называется коэффициентом сжатия. Он показывает, до какой величины можно сжать передаваемые сообщения, если устремить избыточность. Источник, обладающий избыточностью, передает излишнее количество сообщений. Это увеличивает продолжительность передачи и снижает эффективность использования канала связи. Сжатие сообщений можно осуществить посредством соответствующего кодирования. Информацию необходимо передавать такими сообщениями, информационная емкость которых используется наиболее полно. Этому условию удовлетворяют равновероятна и независимые сообщения.

Вместе с тем избыточность источника не всегда является отрицательным свойством. Наличие взаимосвязи между буквами текста дает возможность восстанавливать его при искажении отдельных букв, т. е. использовать избыточность для повышения достоверности передачи информации.