Отличительной особенностью рассмотренных ранее каналов без помех является то, что при выполнении условия теоремы Шеннона количество принятой информации на выходе канала всегда равно количеству информации, переданной от источника сообщений. При этом, если на вход канала поступил сигнал ![]() , то на выходе возникает сигнал

, то на выходе возникает сигнал ![]() , вполне однозначно определяющий переданный сигнал

, вполне однозначно определяющий переданный сигнал ![]() . Количество информация, прошедшее по каналу без помех в случае передачи

. Количество информация, прошедшее по каналу без помех в случае передачи ![]() и приема

и приема ![]() равно количеству информации, содержащейся в сигнале

равно количеству информации, содержащейся в сигнале ![]() :

:

![]() (6.40)

(6.40)

Здесь величина вероятности P(![]() ) характеризует ту неопределенность в отношении сигнала

) характеризует ту неопределенность в отношении сигнала ![]() , которая существовала до его передачи. После приема

, которая существовала до его передачи. После приема ![]() в силу однозначного соответствия между

в силу однозначного соответствия между ![]() и

и ![]() неопределенность полностью устраняется.

неопределенность полностью устраняется.

Иное положение имеет место в каналах, где присутствуют различного рода помехи. Их воздействие на передаваемый сигнал приводит к разрушению и необратимой потере части информации, поступающей от источника сообщения. Поскольку в канале с помехами принятому сигналу ![]() может соответствовать передача одного из нескольких сигналов и, то после приема

может соответствовать передача одного из нескольких сигналов и, то после приема ![]() остается некоторая неопределенность в отношении переданного сигнала. Здесь соответствие между u и v носит случайный характер, поэтому степень неопределенности характеризуется условной апостериорной вероятностью P(

остается некоторая неопределенность в отношении переданного сигнала. Здесь соответствие между u и v носит случайный характер, поэтому степень неопределенности характеризуется условной апостериорной вероятностью P(![]() ), причем всегда P(

), причем всегда P(![]() )<1. Количество информации, необходимое для устранения оставшейся неопределенности

)<1. Количество информации, необходимое для устранения оставшейся неопределенности ![]() , очевидно, равно той части информации, которая разрушена вследствие действия помех. Тогда в соответствии с ф-лой (6.5) количество принятой информации определяется как разность

, очевидно, равно той части информации, которая разрушена вследствие действия помех. Тогда в соответствии с ф-лой (6.5) количество принятой информации определяется как разность

![]() (6.41)

(6.41)

Для оценки среднего количества принятой информации при передаче одного сообщения выражение (6.41) необходимо усреднить по всему ансамблю и и v:

(6.42)

(6.42)

где P(![]() ) = p(

) = p(![]() )p(

)p(![]() ) — совместная вероятность переданного и принятого сигналов, ти— количество сигналов и в ансамбле на входе канала и тv — количество сигналов ib ансамбле на выходе канала (в общем случае

) — совместная вероятность переданного и принятого сигналов, ти— количество сигналов и в ансамбле на входе канала и тv — количество сигналов ib ансамбле на выходе канала (в общем случае ![]() ).

).

Величина J(u,v) характеризует в среднем количество информации, которое содержит принятый сигнал v относительно переданного сигнала и, поэтому ее называют также средней взаимной информацией между и и v.

Выражение (6.42) обычно представляют в двух формах. Первая из них

![]() (6.43)

(6.43)

где

![]()

— энтропия источника сигналов u и

![]() (6.45)

(6.45)

— условная энтропия или ненадежность.

Соотношение (6.43) показывает, что среднее количество, принятой информации равно среднему количеству переданной информации Н(и) минус среднее количество информации H(u/v), потерянное в канале вследствие воздействия помех.

Вторая форма записи средней взаимной информации, может быть получена, если в (6.42) подставить выражение для условной вероятности в соответствии с ф-лой (2.26). После соответствующих преобразований получаем

![]() (6.46)

(6.46)

Здесь

![]() (6.47)

(6.47)

энтропия выхода канала и

![]() (6.48)

(6.48)

— условная энтропия, равная, как будет показано ниже, энтропии шума. Она определяет бесполезную часть информации, которая содержится в принятых сигналах за счет действия помех.

Понятия скорости передачи информации и пропускной способности, введенные в § 6.7 для каналов без помех, могут быть использованы и в каналах с помехами. В этом случае скорость передачи информации ло каналу определяется как

![]() (6.49)

(6.49)

где ![]() и

и ![]() — соответственно последовательности передаваемых и принимаемых сигналов длительностью Т.

— соответственно последовательности передаваемых и принимаемых сигналов длительностью Т.

Необходимым условием применимости ф-лы (6.49) является соблюдение свойства эргодичности как для последовательности иT, так и последовательности vT,. Последнее означает, что помехи, действующие в канале, также должны быть эргодическими. По аналогии с (6.29) скорость передачи можно представить с учетом (6.43) и (6.46) в более удобных формах:

![]() (6.50)

(6.50)

Пропускная способность канала с помехами определяется как максимально возможная скорость передачи при заданных ограничениях, накладываемых на передаваемые сигналы:

![]() (6.51)

(6.51)

Для каналов с сигналами одинаковой длительности, равной τ, пропускная способность

![]() (652)

(652)

где максимум ищется по всем возможным ансамблям сигналов u.

Рассмотрим двоичный канал с помехами без памяти, по которому передаются дискретные сигналы, выбранные да ансамбля, содержащего два независимых сигнала u1 и u2 с априорными вероятностями p(u1) и p(u2). На выходе канала образуются сигналы v1 и v2 при правильном приеме отражающие соответственно сигналы u1 и u2. В результате действия помех возможны ошибки, которые характеризуются при передаче u1 условной вероятностью P(![]() ), при передаче и2— условной вероятностью P(

), при передаче и2— условной вероятностью P(![]() ). Вычислим энтропию сигнала (6.47)

). Вычислим энтропию сигнала (6.47)

![]() (6.53)

(6.53)

и энтропию шума (6.48)

![]()

![]() (6.54)

(6.54)

Будем полагать канал симметричным. Для такого канала вероятности переходов одинаковы: ![]() , а полная вероятность ошибки

, а полная вероятность ошибки

![]() (6.55)

(6.55)

Отсюда вытекают соотношения:

(6.56)

(6.56)

После их подстановки в выражение (6.54) получаем

![]() (6.57)

(6.57)

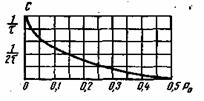

Рис. 6.2. Зависимость пропускной способности двоичного канала от вероятности ошибки Ро

Для того чтобы определить пропускную способность (6.52), необходимо максимизировать J(u,v)=H(v)-H(v/u). При заданной вероятности ошибки, как следует из (6.57), величина H(v/u) .постоянна, а максимум следует искать, изменяя H(v). Энтропия сигнала H(v), выраженная ф-лой (6.53), имеет максимальное значение H0(v)=1 случае равновероятных сигналов, когда P(![]() )=P(

)=P(![]() )=0,5. Подставляя выражения (6.53) и (6.57) в ф-лу (6.52) получим следующее выражение для пропускной способности двоичного симметричного канала:

)=0,5. Подставляя выражения (6.53) и (6.57) в ф-лу (6.52) получим следующее выражение для пропускной способности двоичного симметричного канала:

(6.58)

(6.58)

Для многопозиционного симметричного канала при mu=mv=m>2

(6.59)

(6.59)

На рис. 6.2 приведена зависимость С от вероятности ошибки для двоичного канала (6.58). Увеличение Р0приводит к снижению пропускной способности, которая становится равной нулю при P0=0,5. В этом случае в соответствии с (6.56) полностью исчезает какая-либо зависимость между передаваемыми и принятыми сигналами: ![]() и

и ![]() . Значение P0=1/2 для бинарного канала является предельным.

. Значение P0=1/2 для бинарного канала является предельным.